Calcul du BLER en LTE

Le BLER, ou Block Error Rate, est un indicateur clé de la qualité de la transmission dans les réseaux LTE. Il mesure la proportion de blocs de données reçus erronés par rapport au total des blocs transmis. Aujourd’hui, on va voir en détail comment ce taux d’erreur est calculé, son importance et son impact sur la performance du système LTE.

Qu’est-ce que le BLER ?

Le BLER est défini comme le ratio entre le nombre de blocs reçus avec erreur et le nombre total de blocs reçus. Un bloc ici correspond généralement à une unité de données codée, comme un Transport Block (TB), qui est la base de la transmission sur la couche physique LTE.

- Formule :

BLER = (Nombre de blocs erronés) / (Nombre total de blocs transmis) - Un bloc erroné est détecté via les mécanismes d’intégrité, notamment les CRC (Cyclic Redundancy Check) qui permettent de vérifier si un bloc a subi une corruption pendant la transmission.

Rôle du BLER dans LTE

Le BLER est un critère fondamental dans la gestion radio. Il est utilisé pour :

- Contrôler la qualité de la liaison radio entre l’équipement utilisateur (UE) et la station de base (eNodeB).

- Ajuster dynamiquement les paramètres de transmission, comme la modulation et le codage, dans les algorithmes d’adaptation de modulation et codage (AMC).

- Déclencher des retransmissions via le HARQ (Hybrid Automatic Repeat Request) pour améliorer la fiabilité.

Les étapes du calcul du BLER

Le calcul du BLER en LTE implique plusieurs étapes liées à la réception et au traitement des blocs transmis :

- Réception des blocs : Le récepteur récupère les Transport Blocks transmis sur la couche physique.

- Contrôle d’intégrité : Chaque bloc comporte un CRC. Le récepteur vérifie ce CRC pour détecter les erreurs. Un CRC incorrect signale un bloc erroné.

- Comptage des erreurs : Le nombre total de blocs reçus et le nombre de blocs erronés sont comptabilisés sur une fenêtre temporelle donnée.

- Calcul du ratio : Le BLER est calculé selon la formule définie en divisant le nombre de blocs erronés par le nombre total de blocs reçus.

Particularités du BLER en LTE

Plusieurs points techniques influencent le calcul et l’interprétation du BLER :

- Fenêtre de mesure : Le BLER n’est pas calculé instantanément mais sur une fenêtre glissante, qui peut être de quelques centaines à plusieurs milliers de blocs, pour obtenir une mesure stable.

- Types de blocs : En LTE, plusieurs couches utilisent des blocs : Transport Blocks (TB) pour la transmission principale, mais aussi Code Blocks (CB) dans certains processus de codage. Le BLER s’applique principalement aux TB.

- Impact des retransmissions HARQ : Le système HARQ corrige certaines erreurs via des retransmissions. Le BLER est mesuré après la procédure HARQ, c’est-à-dire sur les blocs finaux décodés.

- Différence avec le BER : Le Bit Error Rate (BER) mesure les erreurs au niveau du bit, tandis que le BLER mesure l’erreur au niveau du bloc. Le BLER est plus pertinent pour LTE car la transmission est organisée par blocs.

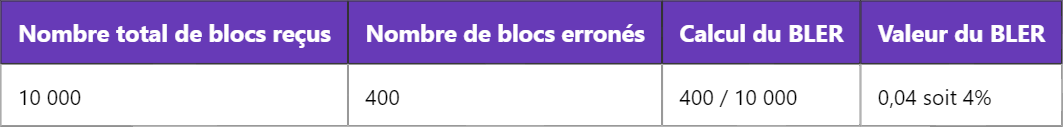

Calcul pratique et analyse du BLER

Supposons un scénario simple où un récepteur LTE reçoit 10 000 blocs sur une période donnée. Parmi eux, 400 blocs présentent une erreur détectée par le CRC. Le BLER est alors :

Un BLER de 4 % indique qu’en moyenne 4 blocs sur 100 sont reçus avec erreur. Cette valeur peut être utilisée par l’eNodeB pour décider de modifier la modulation ou le codage, afin d’améliorer la qualité de la liaison.

Importance du BLER pour la qualité de service

Le BLER influence directement la qualité de service (QoS) perçue par l’utilisateur. Un BLER trop élevé entraîne :

- Augmentation des retransmissions, ce qui dégrade le débit utile.

- Retards dans la transmission des données, impactant les applications en temps réel.

- Une consommation énergétique plus importante pour l’UE à cause des retransmissions.

Les opérateurs LTE fixent souvent un objectif de BLER maximal acceptable, généralement autour de 1% à 10%, selon le type de service et les conditions radio.

Mesure et outils de calcul du BLER

Le BLER peut être mesuré à différents niveaux :

- Au niveau UE : L’UE peut rapporter le BLER au réseau via des rapports périodiques pour ajuster la gestion radio.

- Au niveau eNodeB : La station de base utilise le BLER pour les algorithmes d’optimisation radio.

- Outils de test : En laboratoire ou sur le terrain, des outils spécifiques (analyseurs de protocole, simulateurs radio) permettent de calculer précisément le BLER à partir des données reçues.

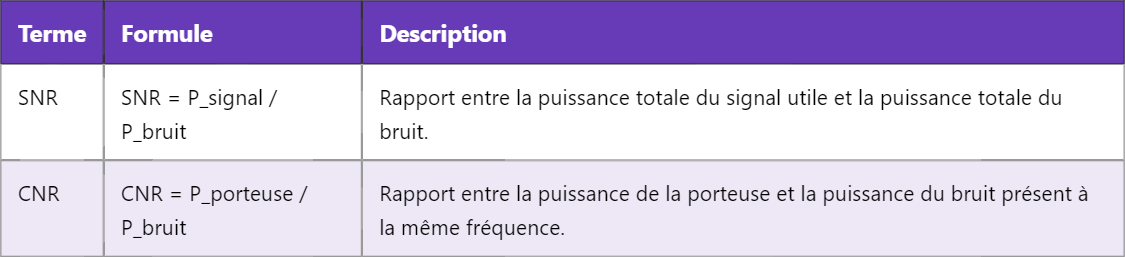

BLER et autres métriques de performance

Le BLER est souvent combiné avec d’autres indicateurs pour une analyse complète :

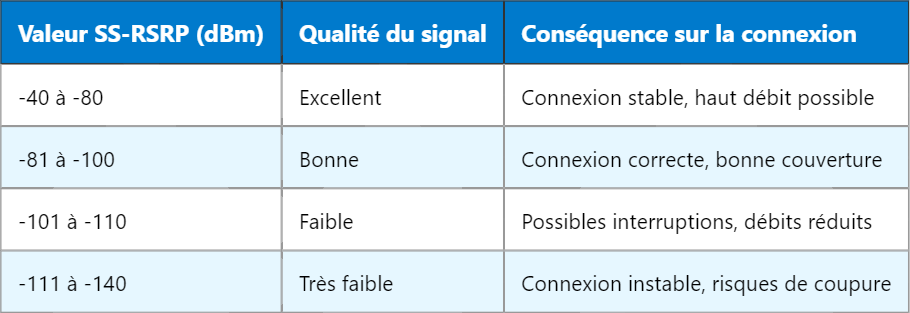

- SINR (Signal to Interference plus Noise Ratio) : Le rapport signal sur bruit et interférences influe directement sur le BLER.

- RSRP/RSRQ : Les mesures de puissance et qualité des signaux de référence aident à anticiper le BLER.

- Throughput : Un BLER élevé diminue le débit net à cause des retransmissions.

En résumé, le BLER est un indicateur fondamental pour le contrôle adaptatif du lien radio en LTE, influençant la robustesse et la performance globale du réseau.

Pour approfondir, on peut explorer comment le BLER est utilisé dans les mécanismes avancés de gestion radio comme le link adaptation et le scheduling dynamique.